OpenCode 一个神奇的CLI (可以融合Claude Code, iFLow, Copilot, Google, 阿里,智谱等)

简介

https://opencode.ai/

https://opencode.ai/docs

- OpenCode 是一个开源代理,可帮助您直接从终端编写和运行代码。

- 原生 TUI响应式、原生、可主题化的终端 UI

- 启用 LSP自动为 LLM 加载正确的 LSP

- 多会话在同一项目上并行启动多个代理

- 分享链接共享指向任何会话的链接以供参考或调试

- Claude Pro 使用 Anthropic 登录以使用您的 Claude Pro 或 Max 帐户

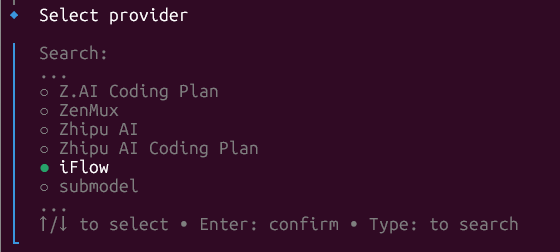

- 通过 Models.dev 的任何模型 75+ LLM 提供商,包括本地模型

- 任何编辑器OpenCode 在您的终端中运行,将其与任何 IDE 配对

安装命令

curl -fsSL https://opencode.ai/install | bash

或

npm i -g opencode-ai

运行方式:

opencode #正常运行

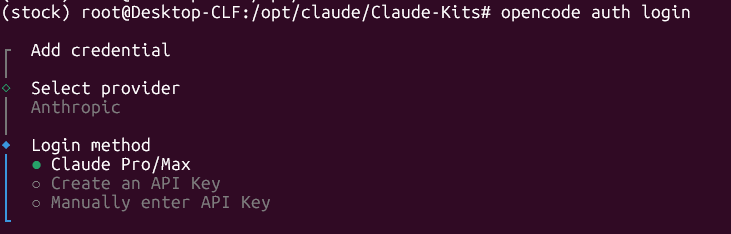

opencode auth login #使用其它方式运行,这里可以选 Anthropic, 连接到Claude Code, 或者 iFlow,太强了

我刚研究出一个方法,先用opencode auth login, 调起iflow, 把key配置好,再[安装openspec](npm install -g @fission-ai/openspec@latest), 然后进入项目目录,openspec init, 然后启动opencode, 就可以用/openspec命令了,比speckit好像更强一些。

https://github.com/Fission-AI/OpenSpec

https://opencode.ai/docs

设置文件

~/.local/share/opencode/auth.json

Credentials

When you add a provider’s API keys with opencode auth login, they are stored in ~/.local/share/opencode/auth.json.

Config

You can customize the providers through the provider section in your OpenCode config.

~/.config/opencode/package.json

设置不同的AI入口,参考:https://opencode.ai/docs/providers/

Ollama

{

"$schema": "https://opencode.ai/config.json",

"provider": {

"ollama": {

"npm": "@ai-sdk/openai-compatible",

"name": "Ollama (local)",

"options": {

"baseURL": "http://localhost:11434/v1"

},

"models": {

"llama2": {

"name": "Llama 2"

}

}

}

}

}

在此示例中:

ollama是自定义提供程序 ID。这可以是您想要的任何字符串。

npm指定要用于此提供程序的包。这里,用于任何与 OpenAI 兼容的 API。@ai-sdk/openai-compatible

name是 UI 中提供程序的显示名称。

options.baseURL是本地服务器的端点。

models是模型 ID 到其配置的映射。模型名称将显示在模型选择列表中。

其他提供商

在项目目录中创建或更新文件:opencode.json

{

"$schema": "https://opencode.ai/config.json",

"provider": {

"myprovider": {

"npm": "@ai-sdk/openai-compatible",

"name": "My AI ProviderDisplay Name",

"options": {

"baseURL": "https://api.myprovider.com/v1"

},

"models": {

"my-model-name": {

"name": "My Model Display Name"

}

}

}

}

}

以下是配置选项:

npm:要使用的 AI SDK 包,适用于 OpenAI 兼容提供商@ai-sdk/openai-compatible

name:UI 中的显示名称。

型号:可用型号。

options.baseURL:API 端点 URL。

options.apiKey:如果不使用身份验证,则可选择设置 API 密钥。

options.headers:(可选)设置自定义标头。

在下面的示例中详细介绍高级选项。

运行该命令,您的自定义提供程序和模型将显示在选择列表中。/models

一个示例:

下面是设置 、 和 model 选项的示例。apiKeyheaderslimit

{

"$schema": "https://opencode.ai/config.json",

"provider": {

"myprovider": {

"npm": "@ai-sdk/openai-compatible",

"name": "My AI ProviderDisplay Name",

"options": {

"baseURL": "https://api.myprovider.com/v1",

"apiKey": "{env:ANTHROPIC_API_KEY}",

"headers": {

"Authorization": "Bearer custom-token"

}

},

"models": {

"my-model-name": {

"name": "My Model Display Name",

"limit": {

"context": 200000,

"output": 65536

}

}

}

}

}

}

配置详细信息:

apiKey:使用变量语法设置,了解更多:.env

headers:随每个请求发送的自定义标头。

limit.context:模型接受的最大输入令牌数。

limit.output:模型可以生成的最大令牌数。

这些字段允许 OpenCode 了解您还剩下多少上下文。标准提供商会自动从 models.dev 中提取这些内容。limit

oh-my-opencode 插件

这里没有为了显摆而疯狂烧 Token 的臃肿 Subagent。没有垃圾工具。

这是烧了 24,000 美元 Token 换来的、真正经过生产环境验证、测试、靠谱的 Harness。 拿着你的 ChatGPT、Claude、Gemini 订阅直接就能用。我们全包圆了。

https://github.com/code-yeongyu/oh-my-opencode

https://github.com/code-yeongyu/oh-my-opencode/blob/dev/README.zh-cn.md

如果你像我一样,遇到以下问题:

最简单的:把下面的提示词扔给opencode:

按照以下说明安装和配置

https://raw.githubusercontent.com/code-yeongyu/oh-my-opencode/refs/heads/master/README.md

配置已经正确保存了!现在让我为你总结配置并提供认证指导:

✅ 配置完成总结

你的 Oh My OpenCode 已配置以下代理:

主要代理

- Sisyphus (主协调器): google/antigravity-claude-opus-4-5-thinking-high

- 负责整体任务规划和编排

专业代理

- Oracle (架构师): google/antigravity-claude-opus-4-5-thinking-high

- 架构设计、代码审查、策略分析

- Librarian (研究员): google/antigravity-claude-sonnet-4-5

- 多仓库分析、文档查找、实现示例研究

- Explore (探索者): google/gemini-3-flash

- 快速代码库探索和模式匹配

- Frontend UI/UX Engineer: google/gemini-3-pro-high

- 构建精美前端界面

- Document Writer: google/gemini-3-flash

- 撰写技术文档

- Multimodal Looker: google/gemini-3-flash

- 分析 PDF、图像和图表

其他功能

- ✅ Ralph Loop 已启用(自动循环直到任务完成)

- ✅ 后台任务并发已优化

- ✅ Sisyphus 编排已启用

🔐 下一步:认证

要使用这些模型,你需要通过 Google Antigravity 认证。请在终端运行:

opencode auth login

看到这里,如果你和我一样,用不了Google

就用下面的提示词:

我看到Oh My OpenCode 已配置以下代理,但都是google的,如果我用不了 Antigravity怎么办?能不能出一个替代方案?使用其他模型?比如Claude sonnet,

glm-4.7, minimax, 或其他可用的模型。

Opencode工作中:

● 好问题!让我帮你创建一个不依赖 Antigravity 的替代方案。首先,让我了解一下你有哪些可用的模型:

● User answered Claude's questions:

⎿ · 你目前有哪些可用的模型或 API 密钥?(可多选) → GLM-4.7 (智谱AI), MiniMax, OpenAI 兼容接口

● 好的!让我帮你配置这些模型。首先让我检查一下 OpenCode 当前支持哪些 provider:

● Bash(opencode provider list 2>/dev/null || echo "Command not available")

⎿ ▄

█▀▀█ █▀▀█ █▀▀█ █▀▀▄ █▀▀▀ █▀▀█ █▀▀█ █▀▀█

█░░█ █░░█ █▀▀▀ █░░█ █░░░ █░░█ █░░█ █▀▀▀

… +43 lines (ctrl+o to expand)

● 让我查看可用的模型:

● Bash(opencode models 2>&1 | head -50)

⎿ opencode/big-pickle

opencode/glm-4.7-free

opencode/gpt-5-nano

… +47 lines (ctrl+o to expand)

● 太好了!我看到你已经有很多可用的模型了,不需要 Antigravity!让我为你创建一个使用这些模型的配置方案:

● Read(/home/user/.config/opencode/oh-my-opencode.json)

然后我继续提示词:

我不想每次切换模型,都要去修改底层代码,能不能设计一个开关,可用google的用户打开它就用google的模型。不能用google的用户,就可以使用其他模型代替。二者用不同的json配置文件实现切换。

● 非常好的想法!让我设计一个优雅的切换方案。我会创建多个配置文件和一个简单的切换脚本:

● Write(/home/user/.config/opencode/oh-my-opencode.google.json)

⎿ Wrote 58 lines to ../../../home/user/.config/opencode/oh-my-opencode.google.json

Create file ../../../home/user/OMO-CONFIG-GUIDE.md

然后过一会儿,它就实现了:

╌╌╌╌╌╌╌╌╌╌╌╌╌╌╌╌╌╌╌╌╌╌╌╌╌╌╌╌╌╌╌╌╌╌╌╌╌╌╌╌╌╌╌╌╌╌╌╌╌╌╌╌╌╌╌╌╌╌╌╌╌╌╌╌╌╌╌╌╌╌╌╌╌╌╌╌╌╌╌╌╌╌╌╌╌╌╌╌╌╌╌╌╌╌╌╌╌╌╌╌╌╌╌╌╌╌╌╌╌╌╌╌╌╌╌╌╌╌╌╌╌╌╌╌╌╌╌╌╌╌╌╌╌╌╌╌╌╌╌╌╌╌╌╌╌╌╌╌╌╌

# Oh My OpenCode 配置切换指南

## 📋 概述

我们已经创建了一个灵活的模型配置系统,可以根据你的需求在以下两种配置之间切换:

1. **Google Antigravity 配置** - 使用 Google 的 Claude 和 Gemini 模型(需要 Antigravity 认证)

2. **替代模型配置** - 使用 GLM-4.7、DeepSeek、MiniMax 等模型(不需要特殊认证)

## 🎯 当前配置

你正在使用:**替代模型配置 (alternative-models)**

### 代理模型分配 (当然,这个可以改)

| 代理 | 模型 | 用途 |

|---|---|---|

| Sisyphus (主协调器) | iflowcn/deepseek-v3.2 |

整体任务规划和编排,深度推理 |

| Oracle (架构师) | iflowcn/deepseek-v3.2 |

架构设计、代码审查、策略分析 |

| Librarian (研究员) | opencode/glm-4.7-free |

多仓库分析、文档查找、实现示例研究 |

| Explore (探索者) | iflowcn/glm-4.6 |

快速代码库探索和模式匹配 |

| Frontend UI/UX | opencode/glm-4.7-free |

构建精美前端界面 |

| Document Writer | opencode/glm-4.7-free |

撰写技术文档 |

| Multimodal Looker | google/gemini-3-flash |

分析 PDF、图像和图表 |

🔄 配置切换方法

方法 1:使用快捷命令(推荐)

# 重新加载 bash 配置

source ~/.bashrc

# 切换到 Google Antigravity 配置

omo-google

# 切换到替代模型配置

omo-alt

# 查看当前配置

omo-status

方法 2:使用完整脚本

# 切换到 Google 配置

~/.config/opencode/switch-omo-config.sh google

# 切换到替代模型配置

~/.config/opencode/switch-omo-config.sh alternative

# 查看当前状态

~/.config/opencode/switch-omo-config.sh status

📂 配置文件位置

所有配置文件位于:~/.config/opencode/

oh-my-opencode.json- 当前激活的配置(符号链接)oh-my-opencode.google.json- Google Antigravity 模型配置oh-my-opencode.alternative.json- 替代模型配置switch-omo-config.sh- 配置切换脚本oh-my-opencode.backup.*.json- 自动备份的旧配置

基本使用

# 启动 OpenCode

opencode

# 在提示词中使用 ultrawork 或 ulw 关键词激活完整功能

"请帮我实现这个功能,ultrawork"

调用专业代理

# 架构审查

Ask @oracle to review this design and propose an architecture

# 代码研究

Ask @librarian how this is implemented—why does the behavior keep changing?

# 快速探索

Ask @explore for the policy on this feature

Ralph Loop(持续工作模式)

# 让代理持续工作直到任务完成

/ralph-loop "实现用户认证功能"

# 取消 Ralph Loop

/cancel-ralph

🔧 自定义配置

如果你想修改模型分配,可以直接编辑配置文件:

# 编辑替代模型配置

nano ~/.config/opencode/oh-my-opencode.alternative.json

# 或者编辑 Google 配置

nano ~/.config/opencode/oh-my-opencode.google.json

修改后无需切换,配置会立即生效(因为当前配置是符号链接)。

📊 模型性能对比

| 模型 | 推理能力 | 速度 | 成本 | 推荐用途 |

|---|---|---|---|---|

| DeepSeek V3.2 | ⭐⭐⭐⭐⭐ | ⭐⭐⭐ | 免费 | 复杂任务、架构设计 |

| GLM-4.7 | ⭐⭐⭐⭐ | ⭐⭐⭐⭐ | 免费 | 代码理解、文档写作 |

| GLM-4.6 | ⭐⭐⭐ | ⭐⭐⭐⭐⭐ | 免费 | 快速探索、简单任务 |

| Gemini Flash | ⭐⭐⭐ | ⭐⭐⭐⭐ | 免费 | 视觉分析、前端 |

后台任务并发控制

配置文件中已优化并发设置:

"background_task": {

"providerConcurrency": {

"iflowcn": 8, // 智谱 AI 最大并发

"google": 5, // Google 最大并发

"opencode": 5 // OpenCode 最大并发

},

"modelConcurrency": {

"iflowcn/deepseek-v3.2": 3, // DeepSeek 同时运行 3 个任务

"opencode/glm-4.7-free": 8, // GLM-4.7 同时运行 8 个任务

"iflowcn/glm-4.6": 10, // GLM-4.6 同时运行 10 个任务

"google/gemini-3-flash": 5 // Gemini Flash 同时运行 5 个任务

}

}

Ralph Loop 配置

"ralph_loop": {

"enabled": true, // 启用 Ralph Loop

"default_max_iterations": 100 // 最大迭代次数

}

🚨 故障排除

配置未生效

# 检查符号链接是否正确

ls -la ~/.config/opencode/oh-my-opencode.json

# 应该显示类似:

# oh-my-opencode.json -> oh-my-opencode.alternative.json

模型不可用

# 列出所有可用模型

opencode models

恢复默认配置

切换脚本会自动备份你的原始配置。如果需要恢复:

# 查看备份文件

ls -la ~/.config/opencode/oh-my-opencode.backup.*

# 恢复备份

cp ~/.config/opencode/oh-my-opencode.backup.YYYYMMDD_HHMMSS.json \

~/.config/opencode/oh-my-opencode.json

🎉 开始使用

一切就绪!现在你可以:

- 直接使用:

opencode - 添加 ultrawork:在提示词中加入

ultrawork或ulw - 切换配置:

omo-google或omo-alt - 查看状态:

omo-status

享受强大的 AI 代理团队吧!🚀

提示:如果你想使用 Google Antigravity 模型,需要先进行认证:

opencode auth login

# 选择 Provider: Google

# 选择 Login method: OAuth with Google (Antigravity)

然后运行 omo-google 切换配置。

然后按以下步骤操作:

- 选择 Provider: Google

- 选择 Login method: OAuth with Google (Antigravity)

- 在浏览器中完成 Google 登录

- 支持多达 10 个 Google 账号负载均衡

🚀 使用方法

配置完成后,你可以:

- 直接使用:在提示词中包含 ultrawork 或 ulw 关键词

- 调用专业代理:

- "Ask @oracle to review this design"

- "Ask @librarian how this is implemented"

- "Ask @explore for the policy on this feature" - Ralph Loop:使用 /ralph-loop "你的任务" 让代理持续工作直到完成

恭喜!🎉 你已经成功配置了 Oh My OpenCode!

提示:这个项目由 professionals at Indent(开发 Spray、vovushop、vreview 等产品)、Google 和 Microsoft 的专业人士使用。你也可以通过贡献来获得免费推广!

如果你觉得这个项目有帮助,可以考虑给它一个 star ⭐:https://github.com/code-yeongyu/oh-my-opencode

# 继续优化

● ✅ Free Plan 已更新!

现在 minimax-m2.1-free 分配给 Explore (探索者),充分发挥其快速响应的优势!

🆕 新的 Free Plan 配置

┌────────────────────────────┬──────────────────────┬──────────┐

│ 代理 │ 模型 │ 理由 │

├────────────────────────────┼──────────────────────┼──────────┤

│ Sisyphus (主协调器) │ grok-code │ 最强推理 │

├────────────────────────────┼──────────────────────┼──────────┤

│ Oracle (架构师) │ grok-code │ 深度分析 │

├────────────────────────────┼──────────────────────┼──────────┤

│ Librarian (研究员) │ grok-code │ 代码理解 │

├────────────────────────────┼──────────────────────┼──────────┤

│ Explore (探索者) │ minimax-m2.1-free ⚡ │ 快速响应 │

├────────────────────────────┼──────────────────────┼──────────┤

│ Frontend (前端工程师) │ glm-4.7-free │ 中文理解 │

├────────────────────────────┼──────────────────────┼──────────┤

│ Document Writer (文档撰写) │ glm-4.7-free │ 写作能力 │

├────────────────────────────┼──────────────────────┼──────────┤

│ Multimodal (多模态分析师) │ grok-code │ 综合能力 │

└────────────────────────────┴──────────────────────┴──────────┘

💡 为什么给 Explore?

MiniMax M2.1 的特点:

- ⚡ 速度快 - Explore 需要快速搜索代码

- 🎯 轻量任务 - 不需要复杂推理,快速查找即可

- 🔄 释放 grok-code - 让最强的模型专注于高价值任务

📊 模型分配统计

grok-code: 4 个角色 (57%) - 最强推理任务

minimax-m2.1-free: 1 个角色 (14%) - 快速探索任务

glm-4.7-free: 2 个角色 (29%) - 中文写作任务

💬 关于模型切换

你问的非常好!模型是自动切换的,完全不需要手动操作!

🔄 自动切换原理

当你使用 Oh My OpenCode 时:

你 → 主代理 (Sisyphus/grok-code)

↓ 调用 @oracle

Oracle (oracle/grok-code) ← 自动使用 oracle 的模型

↓ 调用 @explore

Explore (explore/minimax-m2.1-free) ← 自动使用 explore 的模型

↓ 调用 @librarian

Librarian (librarian/grok-code) ← 自动使用 librarian 的模型

📝 实际例子

# 在 OpenCode 中输入:

"帮我分析这个项目的架构,ultrawork"

# 自动执行流程:

# 1. Sisyphus (grok-code) 接收任务,规划工作

# 2. 调用 @librarian (grok-code) 分析代码结构

# 3. 调用 @explore (minimax-m2.1-free) 快速搜索文件

# 4. 调用 @oracle (grok-code) 分析架构设计

# 5. Sisyphus (grok-code) 整合结果,生成报告

# 所有模型切换自动完成,无需手动操作!

🎯 在界面上看到的

当代理工作时,你会看到:

[Thinking] Sisyphus (主协调器) 正在规划任务...

↓ 自动切换到 grok-code

[Calling] @oracle (架构师) to analyze architecture...

↓ 自动切换到 grok-code (oracle 的模型)

[Calling] @explore (探索者) to search codebase...

↓ 自动切换到 minimax-m2.1-free (explore 的模型)

[Calling] @librarian (研究员) to find implementations...

↓ 自动切换到 grok-code (librarian 的模型)

[Complete] All agents finished

✅ 总结

- 完全自动 - 系统根据调用的代理自动切换模型

- 无需手动 - 你只需要使用代理,系统自动处理模型切换

- 无缝体验 - 切换过程对用户透明

🚀 立即体验

# 生成新的 Free Plan 配置

omo-gen auto

# 启动 OpenCode

opencode

# 使用 ultrawork,体验自动模型切换

"帮我重构这个代码库,ultrawork"

所有模型切换都是自动的,你完全不需要担心!🎉

● 非常好的问题!模型是完全自动切换的,你完全不需要手动操作!

🔄 自动切换机制详解

工作原理

用户输入

↓

Sisyphus (主协调器) 使用 grok-code 接收任务

↓

├─→ 需要架构分析

│ ↓ 自动调用 @oracle

│ Oracle (架构师) 使用 grok-code 执行任务

│ ↓ 返回结果给 Sisyphus

│

├─→ 需要探索代码库

│ ↓ 自动调用 @explore

│ Explore (探索者) 使用 minimax-m2.1-free 执行任务

│ ↓ 返回结果给 Sisyphus

│

└─→ 需要查找实现

↓ 自动调用 @librarian

Librarian (研究员) 使用 grok-code 执行任务

↓ 返回结果给 Sisyphus

Sisyphus 整合所有结果,使用 grok-code 生成最终回答

↓

返回给用户

📝 实际例子

例子 1:使用 ultrawork

# 你在 OpenCode 中输入:

"帮我分析这个项目的架构,ultrawork"

# 后台自动执行(你不需要做任何事):

┌─────────────────────────────────────────────────────┐

│ 1. Sisyphus (主协调器) - grok-code │

│ "理解任务,制定计划" │

├─────────────────────────────────────────────────────┤

│ 2. @oracle (架构师) - grok-code │

│ "分析整体架构设计" ← 自动切换到 oracle 的模型 │

├─────────────────────────────────────────────────────┤

│ 3. @explore (探索者) - minimax-m2.1-free │

│ "快速搜索项目结构" ← 自动切换到 explore 的模型│

├─────────────────────────────────────────────────────┤

│ 4. @librarian (研究员) - grok-code │

│ "查找关键实现" ← 自动切换到 librarian 的模型│

├─────────────────────────────────────────────────────┤

│ 5. Sisyphus (主协调器) - grok-code │

│ "整合所有结果,生成报告" │

└─────────────────────────────────────────────────────┘

例子 2:直接调用特定代理

# 你输入:

"Ask @librarian how authentication is implemented"

# 自动执行:

┌─────────────────────────────────────────┐

│ @librarian (研究员) - grok-code │

│ "搜索认证相关代码" │

│ "分析实现方式" │

│ ← 自动使用 librarian 配置的模型 │

└─────────────────────────────────────────┘

# 如果 librarian 需要快速搜索,它可能会:

┌─────────────────────────────────────────┐

│ @explore (探索者) - minimax-m2.1-free │

│ "快速查找文件" │

│ ← librarian 自动调用 explore │

└─────────────────────────────────────────┘

🎯 配置文件的作用

配置文件 oh-my-opencode.json 定义了每个代理使用的模型:

{

"agents": {

"Sisyphus": {

"model": "opencode/grok-code", ← Sisyphus 使用这个

"description": "Sisyphus (主协调器)"

},

"oracle": {

"model": "opencode/grok-code", ← Oracle 使用这个

"description": "Oracle (架构师)"

},

"explore": {

"model": "opencode/minimax-m2.1-free", ← Explore 使用这个

"description": "Explore (探索者)"

}

}

}

当系统调用这些代理时,会自动使用对应配置的模型。

🔍 如何验证自动切换?

方法 1:查看日志

当代理工作时,你会在输出中看到:

[Thinking] Sisyphus (主协调器) is analyzing...

[Calling] @oracle (架构师) for architecture review...

[Calling] @explore (探索者) for code exploration...

[Complete] Task finished

方法 2:查看配置

omo-status

# 输出:

当前代理模型配置:

Sisyphus: opencode/grok-code

oracle: opencode/grok-code

librarian: opencode/grok-code

explore: opencode/minimax-m2.1-free ← 不同的模型

...

方法 3:实际体验

# 1. 生成配置

omo-gen auto

# 2. 应用配置

omo-alt

# 3. 启动 OpenCode

opencode

# 4. 输入一个复杂任务

"帮我重构这个项目,ultrawork"

# 观察输出,你会看到不同代理被调用

# 每个代理使用自己配置的模型,自动切换

💡 总结

┌──────────────────────┬─────────────────────┐

│ 问题 │ 答案 │

├──────────────────────┼─────────────────────┤

│ 需要手动切换模型吗? │ ❌ 不需要 │

├──────────────────────┼─────────────────────┤

│ 模型自动切换吗? │ ✅ 完全自动 │

├──────────────────────┼─────────────────────┤

│ 我需要做什么? │ ✅ 正常使用代理即可 │

├──────────────────────┼─────────────────────┤

│ 如何配置模型? │ ✅ 配置文件自动处理 │

└──────────────────────┴─────────────────────┘

🎉 体验自动切换

# 立即体验

omo-gen auto && omo-alt && opencode

# 然后输入:

"帮我分析这个代码库并生成文档,ultrawork"

# 你会看到:

# - Sisyphus (grok-code) 协调

# - Oracle (grok-code) 分析架构

# - Explore (minimax-m2.1-free) 快速搜索

# - Librarian (grok-code) 查找实现

# - Document Writer (glm-4.7-free) 生成文档

#

# 所有模型切换自动完成!

完全自动化,无需任何手动操作! 🚀

oh-my-opencode.json 点击查看代码

当前 Oh My OpenCode 的配置文件 (oh-my-opencode.json) 设置如下:

{

$schema: https://raw.githubusercontent.com/code-yeongyu/oh-my-opencode/master/assets/oh-my-opencode.schema.json,

profile: alternative-free,

google_auth: false,

sisyphus_agent: {

disabled: false,

default_builder_enabled: false,

planner_enabled: true,

replace_plan: true

},

agents: {

Sisyphus: {

model: opencode/grok-code,

description: Sisyphus (主协调器)

},

oracle: {

model: opencode/grok-code,

description: Oracle (架构师)

},

librarian: {

model: opencode/grok-code,

description: Librarian (研究员)

},

explore: {

model: opencode/minimax-m2.1-free,

description: Explore (探索者)

},

frontend-ui-ux-engineer: {

model: opencode/glm-4.7-free,

description: Frontend UI/UX Engineer (前端工程师)

},

document-writer: {

model: opencode/glm-4.7-free,

description: Document Writer (文档撰写者)

},

multimodal-looker: {

model: opencode/grok-code,

description: Multimodal Looker (多模态分析师)

}

},

background_task: {

defaultConcurrency: 5,

providerConcurrency: {

anthropic: 3,

google: 5,

opencode: 5,

iflowcn: 8

},

modelConcurrency: {}

},

ralph_loop: {

enabled: true,

default_max_iterations: 100

}

}

主要设置说明:

- profile: 使用 "alternative-free" 配置

- google_auth: 禁用 Google 认证

- sisyphus_agent: 启用,规划器开启,替换计划

- agents: 配置了7个agents,使用不同的模型(主要是 opencode 提供商的免费模型)

- background_task: 默认并发数5,不同提供商的并发限制

- ralph_loop: 启用,默认最大迭代100次

ui-ux-pro-max 在opencode上安装

https://github.com/nextlevelbuilder/ui-ux-pro-max-skill

可以看到,官网上没写支持opencode,怎么办?

直接在opencode对话框里用下面一句prompt:

你能帮我把一个claude code的Skill转化为opencode可用的skill吗?这个skill是ui-ux-pro-max,

请参考https://github.com/nextlevelbuilder/ui-ux-pro-max-skill/tree/main/.claude/skills/ui-ux-pro-max下的所有文档

AI中转平台 -- 强烈推荐Claude Code (官方安装 + 中转API + 本地使用无飞机)

首选方法(最快最具性价比,还可以免费试用):claude-code club

注册和试用网址: https://academy.claude-code.club/ )

国内:智谱 GLM Coding

🚀 速来拼好模,智谱 GLM Coding 超值订阅,邀你一起薅羊毛!Claude Code、Cline 等 10+ 大编程工具无缝支持,“码力”全开,越拼越爽!立即开拼,享限时惊喜价!

链接:https://www.bigmodel.cn/

国内:MinMax2.1

🎁 MiniMax 跨年福利来袭!邀好友享 Coding Plan 双重好礼,助力开发体验!

好友立享 9折 专属优惠 + Builder 权益,你赢返利 + 社区特权!

👉 立即参与:https://www.minimaxi.com/

浙公网安备 33010602011771号

浙公网安备 33010602011771号