实用指南:AIOPS_PLATFORM: 强化IT运维的开源人工智能平台

2025-12-15 11:00 tlnshuju 阅读(4) 评论(0) 收藏 举报 简介:AIOPS_PLATFORM是一个旨在提升IT运维效率和自动化的开源平台,整合了DevOps、机器学习、深度学习、NLP和AIOPS技术。它以Python为主编程语言,提供了强大的数据处理和模型训练框架。平台支持快速迭代和部署,增强系统稳定性,并通过预测和自动化响应功能,实现智能运维。AIOPS_PLATFORM的开源性质促进了技术社区的发展和创新。

1. AIOPS_PLATFORM:用于IT运营的人工智能平台

随着企业IT环境的日益复杂化,传统的IT运维方式已经无法满足快速响应和服务质量的要求。在此背景下,AIOPS_PLATFORM应运而生,旨在通过集成人工智能技术优化IT运维流程。本章将介绍AIOPS_PLATFORM的概念、核心功能以及它如何革新IT运维效率。

1.1 AIOPS_PLATFORM的兴起背景

AIOPS_PLATFORM是指在IT运维中应用人工智能技术,实现自动化运维的解决方案。在数字化转型浪潮中,企业面临着海量的数据处理、复杂的服务请求以及不断提升的服务质量要求,这促使IT运维向智能化方向发展。

1.2 AIOPS_PLATFORM的核心功能

AIOPS_PLATFORM通常具备智能预警、故障自愈、性能优化、资源调度和智能分析五大核心功能。通过机器学习模型的预测和分析能力,平台能够在问题发生之前,自动识别潜在风险并采取措施,大大提升了运维效率和服务质量。

AIOPS_PLATFORM的出现,不仅改变了运维人员的工作方式,也推动了整个行业对运维流程的理解和优化。接下来的章节将探讨开源AIOPS平台与传统ITSM的对比,以及如何通过IT运维效率提升策略和自动化流程来实现更深层次的运维革新。

2. IT运维效率的革新

2.1 开源AIOPS平台概述

2.1.1 AIOPS平台定义与核心功能

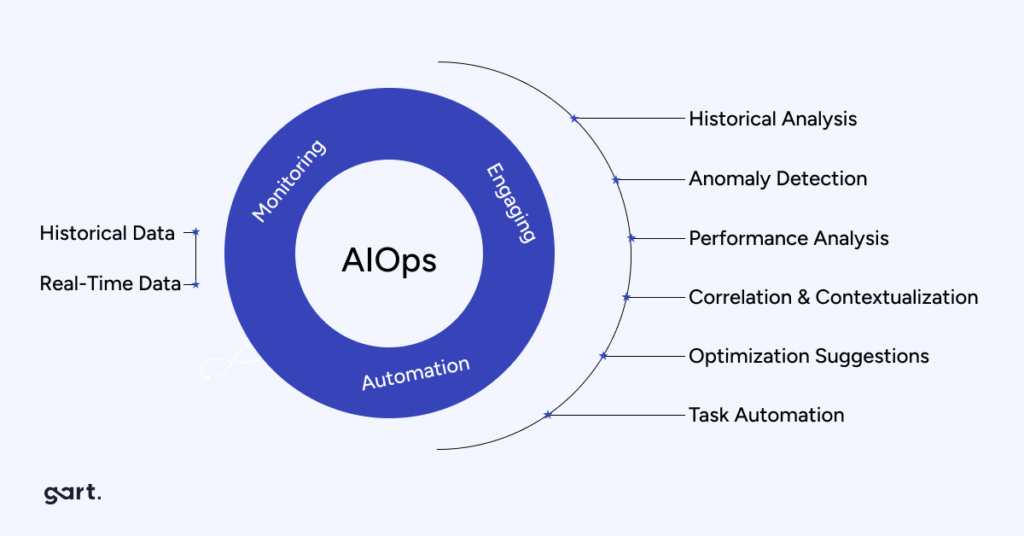

AIOPS(Artificial Intelligence for IT Operations)平台是采用人工智能技术优化IT运维流程的系统。它通过自动化和智能化的方式提升了问题的识别、响应和解决的效率。AIOPS平台的核心功能包括智能监控、故障预测、自动化故障响应、以及性能优化建议等。

2.1.2 开源AIOPS平台与传统ITSM对比

开源AIOPS平台相较于传统IT服务管理(ITSM)工具,在灵活性、可扩展性和成本效益方面具有显著优势。开源平台的社区驱动模式能够快速集成最新的AI技术,并且通常拥有较低的入门门槛,降低了企业采用AIOPS技术的难度和成本。

2.2 IT运维效率提升策略

2.2.1 效率提升的理论基础

提升IT运维效率的理论基础源于不断减少人为干预,自动化重复性任务,并通过智能化手段减少故障处理时间。使用数据驱动的方法来识别系统中的趋势和模式,并基于此进行预测,是提升效率的关键因素。

2.2.2 常见的效率提升案例分析

在IT行业中,案例分析是理解效率提升策略实际应用的重要途径。比如,通过智能监控系统,实时监测网络流量异常,及早发现潜在故障点,可以避免大规模的服务中断。再比如,使用自动化脚本处理常规的软件部署和配置任务,大大节约了人力资源。

2.3 自动化在运维中的角色

2.3.1 自动化流程的原理与优势

自动化是IT运维中的一项重要技术,它将预先定义的指令和工作流转换为程序,自动执行任务。自动化流程能够确保任务的一致性和准确性,同时降低了人为错误,提高了运维效率。

2.3.2 自动化工具和技术选型

选择合适的自动化工具对于实现IT运维自动化至关重要。目前,市场上有多种工具可供选择,例如Ansible、Chef、Puppet等。选择时需要考虑工具的可扩展性、社区支持、集成能力以及易用性。

现在,我们将详细探讨自动化流程的原理及其优势,并对自动化工具和技术进行选型。

自动化流程的原理与优势

自动化流程通过将预先编写的脚本和指令转换为程序,按照既定的逻辑来执行任务。这样不仅提升了任务执行的速度,还可以减少人工干预,从而降低因操作不当引发的错误。自动化流程可以应用于IT运维的多个环节,包括但不限于系统部署、监控、备份、故障响应以及安全扫描等。

优势方面,自动化流程能够:

- 提高处理速度,确保任务按计划执行。

- 减少人力成本,释放员工从事更具创造性的工作。

- 确保执行任务的一致性和准确性。

- 提高系统的可预测性和可控性。

自动化工具和技术选型

在进行自动化工具和技术选型时,通常需要考虑以下几个关键因素:

- 可扩展性 :工具是否能够随着企业的发展和技术环境的变化进行扩展。

- 社区支持 :社区活跃度高,意味着更多的资源和帮助。

- 集成能力 :工具能否与其他工具或系统集成,实现自动化流程的无缝对接。

- 易用性 :学习曲线越平滑,员工接受新工具的速度就越快。

对于初学者和中小企业来说,Ansible因其简洁性、无代理模式以及强大的社区支持而成为一个很好的起点。对于需要更复杂配置管理的环境,Puppet和Chef都是不错的选择。它们提供了模块化的架构,允许创建自定义模块以满足特定需求。

例如,以下是一个使用Ansible的简单任务自动化脚本,它执行了一个基本的系统更新操作:

- name: Update all packages on the Ubuntu server

hosts: ubuntu

become: true

tasks:

- name: Update all packages

apt:

upgrade: dist 在这个Ansible脚本中,我们定义了一个简单的任务,其目的是在所有配置为 ubuntu 的主机上更新所有软件包。这个任务使用了 apt 模块,其中 upgrade: dist 表示升级所有软件包到最新版本。

通过这种方式,运维团队可以快速地对多个系统执行标准化操作,极大地提升了工作效率,同时降低了因忘记执行更新等人为疏忽导致的安全风险。

3. 自动化流程的实践实现

在当前的IT运营领域,自动化流程的实践实现已然是提升效率与可靠性的重要手段。随着技术的不断演进,DevOps理念的引入更是将自动化推向了新的高度。本章将深入探讨自动化流程的实践实现,包括DevOps的引入与实践、集成持续集成(CI)和持续部署(CD)、以及Python在DevOps中的应用。

3.1 DevOps理念的引入与实践

DevOps作为一种文化和实践,其核心在于促进软件开发(Dev)与信息技术运维(Ops)之间的沟通、协作与整合。DevOps的引入是为了解决传统开发和运维之间存在的“壁垒”,实现业务需求的快速响应和服务的持续改进。

3.1.1 DevOps的基本原则

DevOps强调的是一种持续交付和持续集成的文化,它提倡通过自动化手段来提高开发与运维的效率和质量。这一理念包含以下几个基本原则:

- 协作 :打破部门壁垒,鼓励开发、运维、质量保证等团队间的沟通与合作。

- 自动化 :利用自动化工具减少人为错误,提高效率,确保过程的一致性。

- 持续集成和持续部署 :代码经常集成到共享仓库中,且每次提交都可以触发自动化的构建和测试过程。

- 持续反馈 :通过监控和反馈机制快速检测并响应问题。

- 持续改进 :建立持续改进的机制,无论是流程、代码还是文化。

3.1.2 DevOps与传统运维的对比

传统运维往往面临着以下几个问题:

- 长周期 :从开发到上线可能需要数周甚至数月的时间。

- 低效率 :由于手动操作的频繁和复杂,导致了效率低下。

- 高风险 :由于测试和部署周期长,一次性变更的风险较高。

而DevOps的引入则通过整合开发与运维流程、强化自动化和监控、重视人员和流程的持续改进,使这些传统问题得以缓解。它倡导的是一种快速迭代、快速反馈的文化,通过消除传统界限,缩短部署周期,提高系统稳定性和质量。

3.2 DevOps的集成和实践细节

DevOps不是一蹴而就的,它需要有策略地集成持续集成(CI)和持续部署(CD)来实现高效的开发与运维流程。

3.2.1 集成持续集成(CI)和持续部署(CD)

持续集成(CI)是开发人员不断将代码集成到共享仓库中的实践,通常会伴随着自动化测试来确保快速发现和定位问题。通过将每一次代码提交都视为潜在的可部署产品,持续集成成为了高效交付的基础。

持续部署(CD)则是CI的自然延伸,它将软件从构建到测试到发布的各个阶段都自动化起来,从而使得软件可以在任何时候发布到生产环境。

3.2.2 实践中遇到的挑战与解决方案

在实践中,DevOps的推行会面临包括文化、技术、流程等多方面的挑战。对于文化上的挑战,需要建立一种团队间的信任文化,鼓励团队成员分享失败经验并从中学习。技术上的挑战则涉及到选择合适的工具和平台,比如代码版本管理工具Git、自动化测试工具、容器化平台如Docker等。流程上的挑战通常需要定义明确的流程规范和自动化脚本,比如使用Jenkins、GitLab CI/CD等工具来实现流程的自动化。

3.3 Python在DevOps中的应用

Python在DevOps领域中扮演着重要角色,其简洁的语法和丰富的库使得Python脚本成为自动化任务的首选。

3.3.1 Python脚本在自动化中的作用

Python脚本在自动化运维任务中有以下几个优势:

- 简洁易学 :Python的语法简单易懂,便于运维人员快速上手。

- 丰富的库支持 :从网络操作、数据分析到系统管理,Python都有成熟的库可以使用。

- 良好的跨平台性 :Python是跨平台的,可以在不同的操作系统上运行相同的脚本。

- 强大的社区支持 :Python拥有强大的社区,有着大量的资源和框架供人学习和使用。

3.3.2 常用Python模块与工具介绍

下面是一些在DevOps中常用的Python模块和工具:

- Ansible : 通过简单的语法编写脚本,实现服务器的配置管理和应用部署。

- Fabric : 用于操作云平台和服务器部署的基础库。

- Paramiko : 一个实现了SSHv2协议的Python模块,可以用来远程管理服务器。

- SaltStack : 采用Python编写,提供了系统状态和配置管理的工具。

以下是一个简单的Python脚本示例,使用Paramiko模块来远程连接服务器并执行命令:

import paramiko

ssh = paramiko.SSHClient()

ssh.set_missing_host_key_policy(paramiko.AutoAddPolicy())

# 连接到远程服务器

ssh.connect('server.example.com', username='your_username', password='your_password')

# 执行命令并获取输出

stdin, stdout, stderr = ssh.exec_command('df -h')

output = stdout.read()

print(output)

# 关闭连接

ssh.close()Python脚本逻辑分析与参数说明

上述脚本中,我们首先导入了paramiko模块,然后设置了SSH连接的策略,使得脚本可以自动添加未知的服务器主机密钥。接着我们使用 connect() 函数连接到了远程服务器,并通过用户名和密码进行认证。认证通过后,我们使用 exec_command() 函数执行了一个命令 df -h ,该命令用于查看文件系统磁盘空间使用情况。脚本读取命令的标准输出,并打印结果。最后,关闭了与远程服务器的SSH连接。

参数说明:

- server.example.com :远程服务器的地址。

- your_username :用于连接远程服务器的用户名。

- your_password :用于连接远程服务器的密码。

- df -h :执行的命令,用于查看磁盘空间的使用情况。

通过使用Python脚本进行自动化任务,DevOps团队能够以更高的效率执行任务,同时减少人为错误,提升整个运维过程的可靠性。随着自动化流程的持续实践,组织可以更好地利用其技术资源,实现快速反馈和持续改进的目标。

4. AIOPS中的数据分析与机器学习应用

AIOPS(Artificial Intelligence for IT Operations)平台通过集成先进的数据分析技术和机器学习算法,能够自动识别和预测IT系统中的问题,并给出解决方案,从而显著提高运维效率。数据分析是AIOPS的核心,而机器学习则赋予了系统自我学习和优化的能力。本章将深入探讨AIOPS中数据分析和机器学习应用的多个方面。

4.1 数据处理框架的构建与应用

4.1.1 数据处理流程概述

在AIOPS中,数据处理框架是实现高效数据分析的基石。一个典型的处理流程包括数据采集、数据清洗、数据存储、数据处理、分析和可视化等步骤。数据采集涉及到收集来自各种IT系统和设备的日志数据、性能指标、用户行为等。数据清洗则负责去除不完整、不正确、不相关或不一致的数据。数据存储通常使用数据库管理系统(DBMS)如SQL或NoSQL数据库。而数据处理包括数据转换、归一化和特征提取等任务,为后续的分析工作做准备。分析阶段运用统计方法、数据挖掘技术及机器学习算法,从数据中提取有用的信息。最后,可视化工具将分析结果转换为易于理解的形式,帮助运维人员做出决策。

4.1.2 实际案例:数据清洗与预处理

作为数据处理流程的一部分,数据清洗与预处理对于提高数据质量至关重要。例如,一家金融服务公司可能会收集大量的交易日志数据,其中包含了各种交易类型、金额、时间戳等信息。数据清洗过程中,可能需要处理诸如缺失值、重复记录、异常值等问题。下面是一个简单的Python代码示例,使用pandas库来清洗数据:

import pandas as pd

# 假设 df 是一个包含日志数据的DataFrame

# 处理缺失值

df.fillna(method='ffill', inplace=True) # 前向填充

# 删除重复记录

df.drop_duplicates(inplace=True)

# 处理异常值,比如异常的交易金额

outliers = df['amount'][(df['amount'] < 10) | (df['amount'] > 10000)]

df = df[~df['amount'].isin(outliers)]

# 特征归一化,例如对交易金额进行归一化处理

from sklearn.preprocessing import MinMaxScaler

scaler = MinMaxScaler()

df['amount_scaled'] = scaler.fit_transform(df[['amount']])数据清洗后,数据存储在数据库中,并为后续的机器学习分析做准备。对于数据预处理,我们通常需要进行特征工程,提取对预测任务有用的信息。在机器学习模型的训练过程中,数据会被进一步分割为训练集和测试集,以评估模型的性能。

4.2 监督学习和无监督学习实践

4.2.1 监督学习与无监督学习的基本理论

监督学习算法在有标签数据的基础上训练模型,这些标签提供了关于数据点的正确输出信息。在IT运维中,监督学习可以用于预测系统故障、分类用户行为等。常见的监督学习算法包括逻辑回归、支持向量机(SVM)、决策树和随机森林等。

相比之下,无监督学习处理的是未标记的数据,它旨在发现数据中的自然结构或模式。聚类分析是无监督学习中的一种常见方法,比如使用K均值(K-means)算法来将相似的数据点分组在一起。

4.2.2 实际应用:数据分类与聚类分析

假设我们需要对IT系统中的用户行为进行分析,以识别潜在的不正常访问模式。我们可以使用监督学习中的分类算法。首先,我们需要为训练模型准备一个数据集,其中包括正常和异常用户行为的标签。以下是使用scikit-learn库中的随机森林算法来训练一个分类模型的代码示例:

from sklearn.ensemble import RandomForestClassifier

from sklearn.model_selection import train_test_split

# 假设X是特征数据集,y是标签(1表示正常访问,0表示异常访问)

X_train, X_test, y_train, y_test = train_test_split(X, y, test_size=0.2, random_state=42)

clf = RandomForestClassifier(n_estimators=100)

clf.fit(X_train, y_train)

# 评估模型性能

accuracy = clf.score(X_test, y_test)对于无监督学习,聚类分析可以应用于日志数据分析,来识别可能的异常行为。以下是使用K均值算法对交易数据进行聚类的示例:

from sklearn.cluster import KMeans

# 假设dfTransaction是包含交易特征的DataFrame

kmeans = KMeans(n_clusters=3, random_state=42).fit(dfTransaction[['feature1', 'feature2']])

dfTransaction['cluster'] = kmeans.labels_

# 分析聚类结果,判断哪个聚类可能包含异常交易

# ...通过这些分析,我们可以发现数据中的模式,并采取预防性措施来避免潜在的问题。

4.3 深度学习与NLP技术的结合

4.3.1 深度学习在数据分析中的应用

深度学习是机器学习的一个子领域,它通过模拟人脑的神经网络进行学习。深度学习在图像识别、语音识别和自然语言处理等领域取得了重大成功。在AIOPS中,深度学习可以用于处理和分析复杂的IT运维数据,如系统日志、性能数据和网络流量等。它可以提取深层次的数据特征并用于更复杂的预测任务,比如故障预测和异常检测。

4.3.2 NLP机器学习在文本处理中的应用

自然语言处理(NLP)是深度学习应用的一个重要分支,它允许计算机理解和解释人类语言。在AIOPS平台中,NLP可以帮助自动化处理和分析IT运维相关的文本数据,例如日志文件、故障报告和用户反馈。利用NLP技术,系统可以自动提取关键信息,并转化为结构化数据,从而帮助运维人员更快地定位和解决IT问题。

例如,使用BERT等预训练模型可以对大量日志数据进行快速分类和分析。以下是一个使用transformers库中BERT模型进行文本分类的代码示例:

from transformers import BertTokenizer, BertForSequenceClassification

from transformers import pipeline

# 加载预训练模型和分词器

model_name = 'bert-base-uncased'

tokenizer = BertTokenizer.from_pretrained(model_name)

model = BertForSequenceClassification.from_pretrained(model_name)

# 创建一个NLP管道进行分类任务

nlp = pipeline("sentiment-analysis", model=model, tokenizer=tokenizer)

# 假设 log_message 是一条需要分析的日志信息

result = nlp(log_message)通过这些技术的结合应用,AIOPS平台能够更有效地处理和分析IT运维数据,从而提高系统的稳定性和运维效率。

在下一章节中,我们将深入探讨智能预测模型的构建与优化,以及自动化响应系统的设计与实现。

5. 智能预测与自动化响应系统

在现代IT运维的众多挑战中,预测性分析和自动化响应系统扮演着关键角色。这些系统利用先进的数据分析技术,旨在实现对潜在问题的早期识别和快速响应。本章将深入探讨智能预测模型的构建以及自动化响应系统的设计与实现。

5.1 智能预测模型的构建

5.1.1 预测模型的理论基础

预测模型的建立依赖于大量的历史数据和先进的分析算法。这些模型可以基于统计学、机器学习、深度学习等多种理论构建,旨在从历史事件中学习模式,并预测未来可能发生的情况。

统计模型,如时间序列分析,专注于数据的时序特性,通过历史数据的统计规律来预测未来。机器学习模型,如随机森林、梯度提升决策树(GBDT)等,通过学习历史数据中的特征,可以处理更为复杂的数据关系。深度学习模型,如卷积神经网络(CNN)和循环神经网络(RNN),对于非结构化数据(如文本、图像)的预测提供了强大的能力。

5.1.2 实践案例:预测模型的构建与优化

以一个典型的预测场景为例,假设我们需要构建一个模型来预测IT系统中的硬件故障。以下是构建预测模型的步骤:

- 数据收集:首先需要收集相关硬件的历史运维数据,包括温度、电压、负载等传感器数据,以及维修记录和硬件更换记录。

- 数据预处理:清洗数据,填补缺失值,处理异常值,并进行特征工程,如特征提取和选择。

- 模型选择:根据数据的特性和业务需求选择合适的预测模型。例如,可以尝试基于时间序列的ARIMA模型,或者使用机器学习中的GBDT模型。

- 模型训练:使用历史数据训练模型,调整模型参数,使用交叉验证等方法防止模型过拟合。

- 模型评估:使用验证集评估模型的准确性,调整模型直至满足业务需求。

- 部署实施:将训练好的模型部署到生产环境中,开始进行实际的预测工作。

- 模型监控与优化:持续监控模型性能,收集反馈数据,定期重新训练模型,确保模型准确性。

5.1.3 代码实现

以下是一个简单的Python代码示例,展示如何使用 scikit-learn 库中的GBDT模型进行故障预测:

from sklearn.ensemble import GradientBoostingClassifier

from sklearn.model_selection import train_test_split

from sklearn.metrics import accuracy_score

# 假设 X 是特征数据集,y 是标签(是否发生故障)

X, y = load_your_data()

# 分割数据集为训练集和测试集

X_train, X_test, y_train, y_test = train_test_split(X, y, test_size=0.2, random_state=42)

# 创建 GBDT 分类器实例

gbdt = GradientBoostingClassifier(n_estimators=100, learning_rate=0.1, max_depth=3, random_state=42)

# 训练模型

gbdt.fit(X_train, y_train)

# 进行预测

predictions = gbdt.predict(X_test)

# 评估模型准确性

print(f'Accuracy: {accuracy_score(y_test, predictions)}') 在上述代码中, load_your_data() 函数需要被替换为实际加载数据的代码。 GradientBoostingClassifier 是用于构建GBDT模型的类。通过 train_test_split 函数,数据被分为训练集和测试集,以评估模型性能。最后,模型在测试集上的预测结果通过 accuracy_score 函数进行评估。

5.1.4 参数说明与逻辑分析

在上述代码中, GradientBoostingClassifier 的参数 n_estimators 设置为100,表示模型将使用100个决策树进行集成学习; learning_rate 设置为0.1,这是一个控制模型学习速度的参数,较高的学习率可能导致模型过拟合; max_depth 设置为3,表示树的最大深度,限制深度可以防止模型过于复杂。

通过逻辑分析,GBDT模型的优势在于能够自动处理特征选择和模型超参数调整,是一种鲁棒的模型,特别是在处理大量特征和样本数据时。然而,需要对模型进行适当的调整和优化,才能达到最佳性能。

5.2 自动化响应系统的设计与实现

5.2.1 自动化响应的理论与方法

自动化响应系统的核心是根据预测模型提供的信息,自动执行一系列预定义的任务,以响应潜在的问题。这些响应措施可以是重启服务、扩容资源、切换备用系统等。

设计自动化响应系统时,关键步骤包括:

- 确定触发条件:定义哪些情况会触发自动响应流程,例如当预测模型判断硬件故障的概率高于阈值时。

- 制定响应策略:基于不同的触发条件制定响应策略,如通知IT运维团队,自动部署新资源,或执行特定的修复脚本。

- 实施与测试:将策略实施到自动化工具中,并进行充分的测试,确保在真实情况下能够可靠地执行。

- 监控与反馈:实施后持续监控系统的性能,收集反馈,并根据实际情况调整响应策略。

5.2.2 实现自动化响应系统的关键技术

实现自动化响应系统的关键技术包括:

- 自动化工具:如Ansible、Chef、Puppet等,它们能够自动化配置管理、部署流程和日常任务。

- 事件管理:系统如Splunk或ELK Stack可以实时监控日志和事件,及时发现异常情况。

- 消息传递与通知:如使用消息队列(RabbitMQ、Kafka)和邮件/短信/即时通讯工具来传递信息和通知相关人员。

5.2.3 代码实现

以下是一个使用Ansible进行自动化任务调度的示例:

- name: "Fault response automation"

hosts: servers

tasks:

- name: "Check if a fault is predicted"

command: "check_fault.sh"

register: predicted_fault

failed_when: predicted_fault.rc != 0

- name: "Execute automated recovery"

command: "automated_recover.sh"

when: predicted_fault is defined and predicted_fault.rc == 0 在这个Ansible playbook中,首先定义了一个任务来检查系统是否预测到故障。 check_fault.sh 是一个脚本,如果预测到故障,则返回非零退出代码。通过 register 指令,脚本的输出被保存到 predicted_fault 变量中。在第二个任务中,如果检测到故障,将执行 automated_recover.sh 脚本来自动化修复。

5.2.4 参数说明与逻辑分析

在上述Ansible playbook中, hosts 指令指定了任务将在哪些服务器上执行,而 tasks 指令定义了具体任务列表。 name 字段为任务提供描述性名称,而 command 模块用于在目标服务器上执行指定命令。 register 指令将命令输出保存到变量中,而 failed_when 指令定义了当命令失败时应采取的行动。

通过逻辑分析,我们可以看到,通过Ansible的条件执行功能( when 指令),可以基于特定条件自动化执行任务。这种自动化能力对于响应预测模型触发的事件至关重要。

表格展示

| 预测模型 | 适用场景 | 特点 | 挑战 |

|---|---|---|---|

| 时间序列分析 | 需要预测未来趋势的数据 | 可以处理时间相关的数据 | 对非线性关系建模能力有限 |

| 随机森林 | 结构化数据,多分类问题 | 特征重要性评估和多分类能力 | 对大数据集和高维度数据不友好 |

| 梯度提升决策树(GBDT) | 复杂数据模式,高准确性需求 | 高准确性和鲁棒性 | 训练时间长,模型解释性低 |

| 卷积神经网络(CNN) | 图像和视频数据 | 强大的特征提取能力 | 需要大量数据进行训练 |

| 循环神经网络(RNN) | 时间序列、文本、语音数据 | 可处理序列数据和长距离依赖 | 易出现梯度消失或梯度爆炸问题 |

通过以上表格,可以清晰地比较不同模型的特点和挑战,从而帮助选择合适的模型应用于预测故障。

Mermaid流程图

graph TD

A[开始] --> B[收集历史数据]

B --> C[数据预处理]

C --> D[选择预测模型]

D --> E[训练模型]

E --> F[评估模型]

F --> |满足要求| G[部署模型]

F --> |不满足要求| H[调整模型参数]

H --> E

G --> I[监控模型性能]

I --> |性能下降| J[重新训练模型]

J --> E

I --> |正常| K[自动响应系统]

K --> L[自动执行响应策略]

L --> M[结束]通过mermaid流程图,我们展示了构建预测模型和自动化响应系统的整个流程,从数据收集到自动执行响应策略。

通过上述章节的内容,我们详细了解了智能预测模型的构建和自动化响应系统的设计与实现。这些系统的高效运行,为IT运维提供了强大的支持,实现了从传统被动应对到主动预测和快速响应的转变。随着技术的不断进步,这些系统将更加智能化,更好地服务于现代企业的IT运维管理。

6. 自学习系统与开源社区的价值

6.1 自学习系统优化决策过程

6.1.1 自学习系统的工作原理

自学习系统是一种利用机器学习技术,可以自动优化其性能的系统。它通过从历史数据中学习,不断地调整其决策策略,以适应环境的变化。自学习系统通常包括数据采集、特征提取、模型训练、决策优化等步骤。

- 数据采集 :系统首先需要收集大量的历史运维数据,这些数据可能包括日志文件、系统性能指标、用户行为记录等。

- 特征提取 :然后从采集到的数据中提取出有价值的特征信息,用于后续的分析和学习。

- 模型训练 :使用提取的特征对机器学习模型进行训练,常见的模型有决策树、随机森林、神经网络等。

- 决策优化 :模型训练完成后,系统将模型应用于实时数据,根据模型输出进行决策,并根据反馈结果不断优化模型。

自学习系统的决策过程是迭代和持续改进的,这使得它在动态变化的IT环境中具有很强的适应性和准确性。

6.1.2 自学习系统在运维决策中的应用

自学习系统在IT运维决策中的应用主要体现在问题预测、故障诊断和资源优化等方面。例如,通过分析历史故障数据,自学习系统可以预测潜在的系统故障,并提前采取措施预防。在故障诊断方面,自学习系统可以识别出复杂的故障模式,提供准确的故障定位信息。在资源优化方面,它可以动态调整资源分配策略,以满足不断变化的业务需求和优化成本。

自学习系统在提升IT运维自动化和智能化水平方面发挥着重要作用。通过不断地学习和优化,自学习系统能够显著提高运维效率,减少人为错误,最终达到提升IT服务质量的目的。

6.2 开源对技术社区的影响

6.2.1 开源运动的历史与发展

开源运动始于上世纪末,其核心思想是推动软件的源代码开放,允许用户自由使用、修改和分发。开源软件的兴起对整个IT行业产生了深远的影响。

- 早期开源 :1991年Linux的诞生,是开源运动的一个重要里程碑。Linux内核和各种开源软件的出现,标志着开源理念开始被广泛接受。

- 开源社区 :开源项目通常围绕着一个或多个社区进行发展,社区成员共同协作,对软件进行改进和扩展。

- 商业支持 :随着开源软件的价值被认可,越来越多的商业公司开始支持开源项目,甚至将开源策略纳入其商业计划中。

开源运动不仅促进了软件技术的发展,还推动了IT文化的变革,使得协作、透明和共享成为IT行业的新标准。

6.2.2 开源社区如何推动AIOPS平台的创新与发展

开源社区在推动AIOPS平台的创新和发展方面起到了不可或缺的作用。AIOPS平台的开发和优化往往需要跨学科的协作,开源社区为此提供了绝佳的平台。

- 贡献和迭代 :开源社区的成员可以自由地对项目进行贡献,包括提交代码、改进文档或报告bug。这种开放的参与模式促进了项目的快速迭代和持续完善。

- 知识共享 :开源社区鼓励知识共享,成员之间的交流可以快速传播先进的技术理念和实践经验,这对AIOPS平台的技术创新至关重要。

- 问题解决 :面对复杂的IT运维问题,开源社区可以聚合全球的智慧,共同探索解决方案,这种集体智慧的模式可以加快问题的解决速度,并提高解决方案的质量。

开源社区通过共享、协作和创新,为AIOPS平台提供了强大的支持,推动了整个行业向智能化、自动化的方向发展。

简介:AIOPS_PLATFORM是一个旨在提升IT运维效率和自动化的开源平台,整合了DevOps、机器学习、深度学习、NLP和AIOPS技术。它以Python为主编程语言,提供了强大的数据处理和模型训练框架。平台支持快速迭代和部署,增强系统稳定性,并通过预测和自动化响应功能,实现智能运维。AIOPS_PLATFORM的开源性质促进了技术社区的发展和创新。

浙公网安备 33010602011771号

浙公网安备 33010602011771号