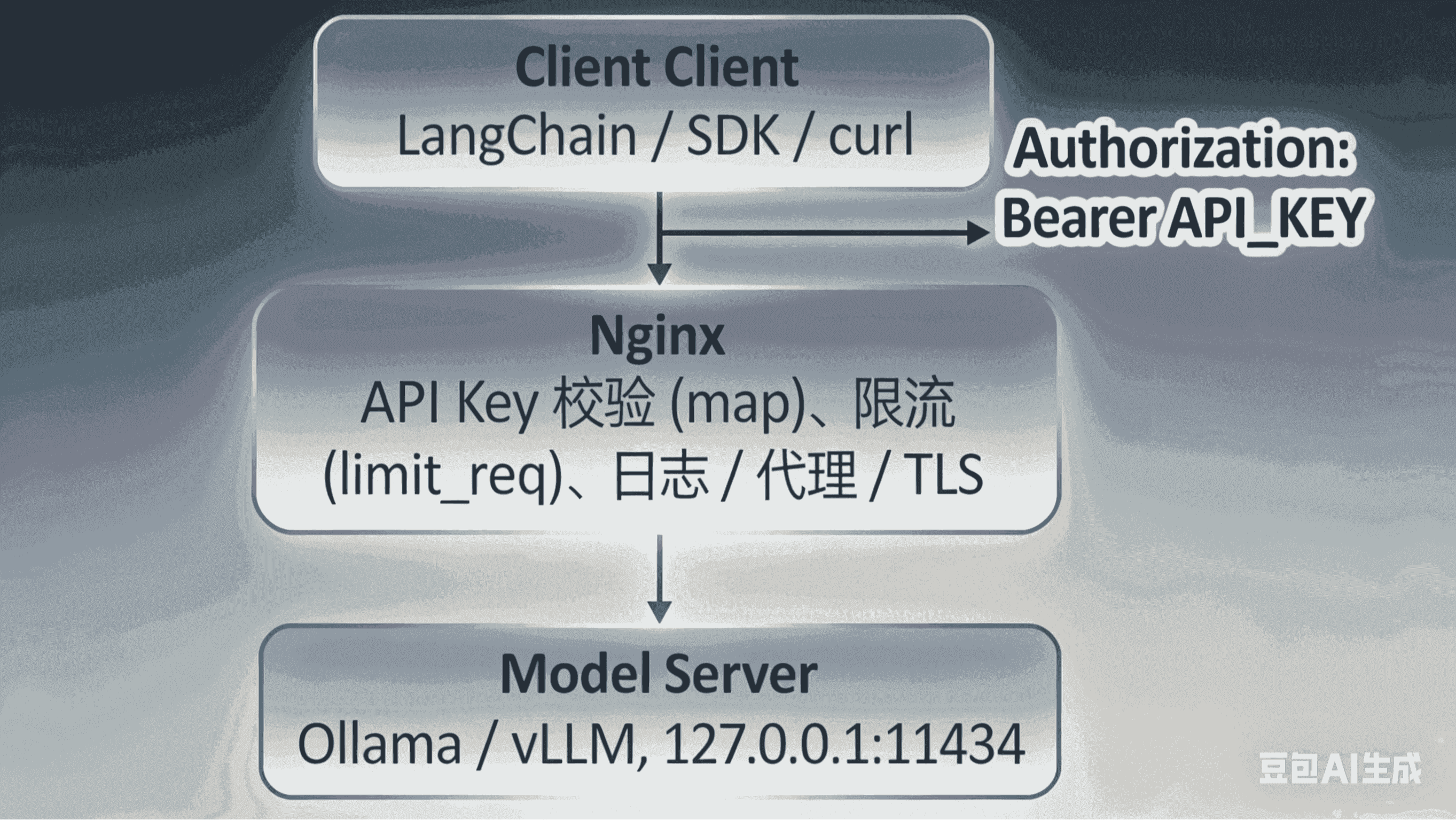

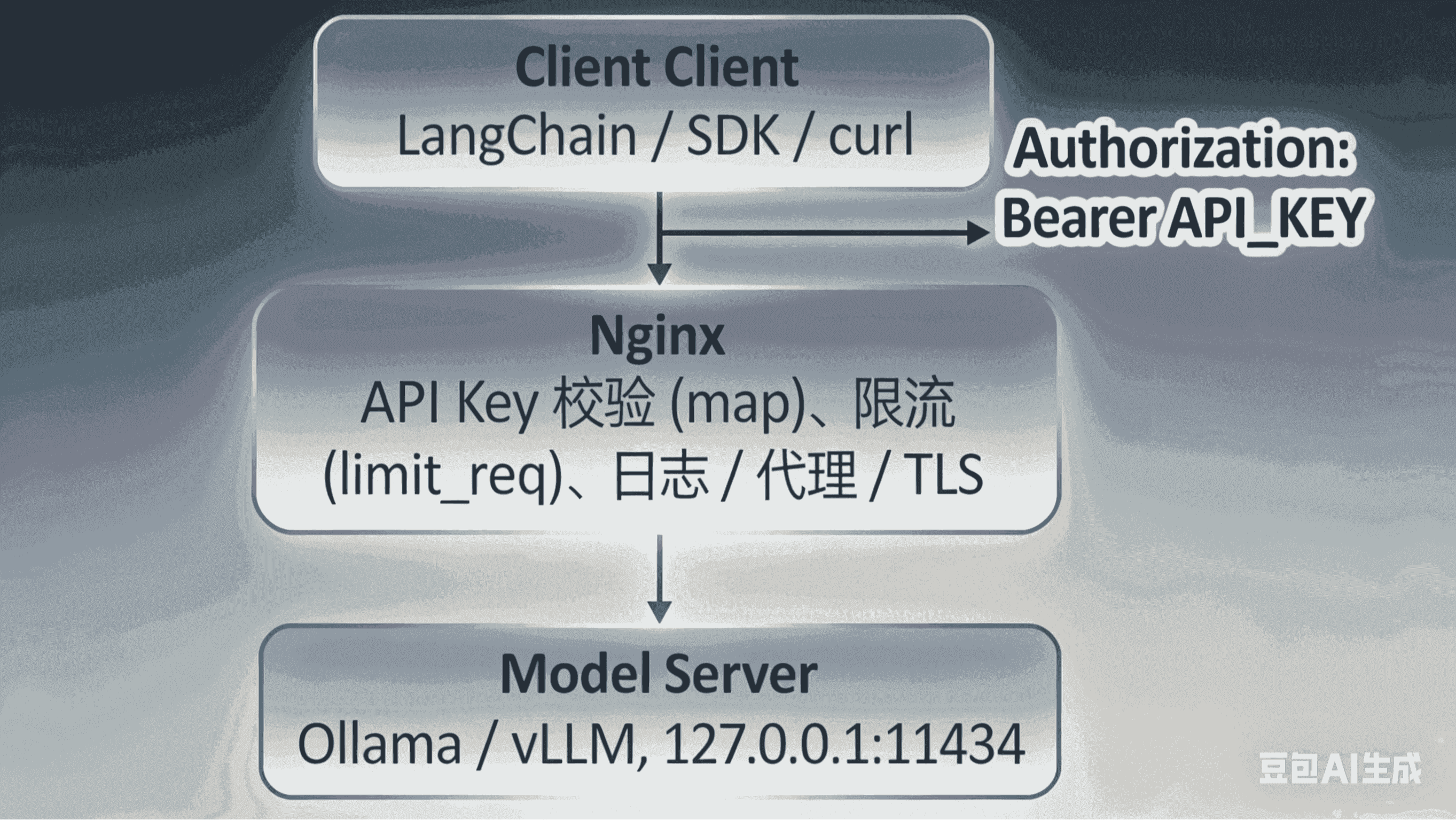

摘要:  在使用 LangChain 开发大模型应用时,我们经常会遇到这样的场景: 使用在线模型(如 OpenAI、通义千问等)时,自带 API Key 认证机制 本地部署的 Ollama、vLLM 等模型服务,默认没有任何认证 在本地或局域网环境下问题还不明显;但一旦你需要: 将模型服务暴露到公网 提供给团 阅读全文

在使用 LangChain 开发大模型应用时,我们经常会遇到这样的场景: 使用在线模型(如 OpenAI、通义千问等)时,自带 API Key 认证机制 本地部署的 Ollama、vLLM 等模型服务,默认没有任何认证 在本地或局域网环境下问题还不明显;但一旦你需要: 将模型服务暴露到公网 提供给团 阅读全文

在使用 LangChain 开发大模型应用时,我们经常会遇到这样的场景: 使用在线模型(如 OpenAI、通义千问等)时,自带 API Key 认证机制 本地部署的 Ollama、vLLM 等模型服务,默认没有任何认证 在本地或局域网环境下问题还不明显;但一旦你需要: 将模型服务暴露到公网 提供给团 阅读全文

在使用 LangChain 开发大模型应用时,我们经常会遇到这样的场景: 使用在线模型(如 OpenAI、通义千问等)时,自带 API Key 认证机制 本地部署的 Ollama、vLLM 等模型服务,默认没有任何认证 在本地或局域网环境下问题还不明显;但一旦你需要: 将模型服务暴露到公网 提供给团 阅读全文

posted @ 2026-01-25 23:27

BugShare

阅读(15)

评论(1)

推荐(0)

浙公网安备 33010602011771号

浙公网安备 33010602011771号